Vous avez probablement déjà entendu parler des robots sur Internet. Vous ne savez peut-être pas ce qu’ils sont ou ce qu’ils font. Pour être bref, les robots Internet ou les robots Web sont des applications qui exécutent automatiquement différentes tâches sur Internet. Ces tâches peuvent être bonnes ou mauvaises. Les bons robots sont généralement utilisés pour automatiser des tâches, comme la numérisation de sites Web ou la collecte de données. Ils sont généralement utilisés pour faciliter notre vie. Cependant, il existe des robots malveillants qui sont utilisé à d’autres fins dans le monde en ligne.

Les robots malveillants sont utilisés pour pirater, spammer, espionner, interrompre et compromettre des sites Web de différentes tailles. Si vous avez une présence en ligne de toute nature, il y a de fortes chances que vous ayez déjà eu des contacts avec ces bots ennuyeux. Il y a des façons de traiter les robots. Les bots représentent près de la moitié du trafic Internet aujourd’hui ( 48,5% pour être exact ), il est donc probable que vous ne pourrez pas les éviter complètement. Cependant, grâce à cet article, vous ne serez plus dérangé par les robots malveillants lors de certains de vos événements.

Nous avons deux solutions pour vous débarrasser des bots sur votre site web, de manière difficile et facile. Commençons avec le manière difficile:

Se débarrasser des robots malveillants de manière difficile

Pourquoi est-ce difficile ? Cette solution demande beaucoup d’efforts de votre part, beaucoup de connaissances et beaucoup de temps. Si vous rencontrez un problème avec les bots qui spamment votre site Web, il faut savoir d’où ils viennent. Tout cela va devenir très technique, alors essayez de suivre le mieux possible. Si vous vous perdez, ne vous inquiétez pas, la manière la plus simple est de ne faire que quelques paragraphes.

Pour savoir d’où viennent les bots et les bloquer, vous aurez besoin de l’adresse IP à laquelle les bots ont été envoyés ou de leur User Agent String. Une adresse IP est unique et sert à identifier chaque ordinateur sur Internet. En revanche, une chaîne d’agent d’utilisateur est le nom du programme réel. Par exemple, un robot de moteur de recherche Google passe par Googlebot / 2.1.

1. Accédez à vos logs

Pour trouver l’une ou l’autre de ces choses, vous devrez accéder à votre journal Web brut. Sur LWS, vous pouvez trouver vos journaux Web brut dans votre espace client. Télécharger les journaux d’accès bruts actuels. Ces fichiers sont généralement assez volumineux et devront être décompressés via un archiveur. Vous pouvez trouver de nombreuses versions d’archiveurs sur le Web ou dans les magasins d’applications. Une fois le fichier décompressé, ouvrez-le dans un éditeur de texte ASCII (comme un Bloc-notes), qui peut également être trouvé sur le Web.

Maintenant, vous devez parcourir le fichier web pour essayer de trouver le bot que vous voulez bloquer. Certains identifiants permettent de connaître l’heure à laquelle le robot a tenté d’accéder à votre site Web. Avec l’un ou l’autre de ces éléments d’information, vous devriez pouvoir localiser une adresse IP ou la chaîne d’agent utilisateur. Une fois que vous avez localisé ces deux éléments d’information, notez-les et préparez-vous à la prochaine étape.

L’étape suivante consiste à bloquer l’adresse IP ou la chaîne d’agent utilisateur. Cependant cela pourrait se retourner contre votre entreprise. Ce n’est pas parce que les bots proviennent d’une adresse IP qu’ils vont provenir de la même adresse IP la prochaine fois qu’ils attaqueront. En bloquant les adresses IP aléatoirement, vous pourriez très bien bloquer tout un fournisseur d’accès Internet (FAI). Les mêmes risques peuvent survenir avec le blocage de certaines chaînes d’agent utilisateur. Les hackers sont intelligents et ils vont souvent nommer leurs robots avec le même nom qu’un logiciel ou navigateur utilisé. Cela devient problématique lorsque vous essayez de bloquer un robot nommé “Safari” par exemple. En effet, cela pourrait bloquer en même temps tous les utilisateurs de ce navigateur Web.

2. Modifier votre fichier .htaccess

Si vous pensez toujours que cette solution en vaut la peine, la prochaine étape consiste à télécharger votre fichier .htaccess.

Un mauvais changement sur votre fichier .htaccess peut potentiellement casser votre site Web. Assurez-vous de sauvegarder votre site Web avant d’apporter d’autres modifications. Pour télécharger votre fichier .htaccess allez dans le répertoire web de votre site depuis votre panneau de contrôle et trouvez le fichier intitulé “.htaccess”. Si vous ne trouvez pas le fichier, il est probable qu’il n’existe pas et vous devrez en créer un.

Si vous avez réussi à trouver le fichier .htaccess, l’étape suivante consiste à l’ouvrir dans votre éditeur de texte ASCII. Vous pouvez ouvrir un nouveau document si vous avez besoin de créer un fichier .htaccess. L’utilisation d’un traitement de texte comme Office, Word ou WordPad pour créer ce fichier peut entraîner l’échec de votre site Web. Assurez-vous donc d’utiliser un éditeur de texte ASCII.

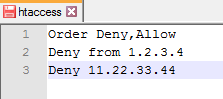

3. Bloquer les adresses IP des robots malveillants

Pour bloquer une adresse IP, ajoutez simplement les lignes de code suivantes à votre fichier .htaccess (il vous suffit d’ajouter l’adresse IP que vous voulez bloquer à la place des exemples d’adresses IP listés ci-dessous):

Si vous avez déjà du texte dans votre fichier .htaccess, ajoutez le code ci-dessus au bas du fichier. Vous pouvez ajouter une autre ligne de code avec le même format “Deny From ___” pour chaque adresse IP que vous souhaitez bloquer. Vous pouvez bloquer autant d’adresses IP que vous le souhaitez, mais notez que plus votre liste est longue, plus votre site Web peut devenir léthargique.

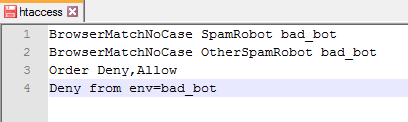

Le blocage d’une chaîne d’agent utilisateur est très similaire au blocage d’adresses IP. Disons que vous avez trouvé un bot que vous voulez bloquer nommé “SpamRobot / 3.1 (+ http: //www.randomsite.com/bot.html)”, vous devez ajouter le code suivant à votre fichier .htaccess (en remplaçant SpamRobot par le bot réel que vous avez trouvé):

Pour ajouter plusieurs chaînes d’agent utilisateur à bloquer, ajoutez simplement une autre ligne de code BrowserMatchNoCase au-dessus de la ligne de code “Refuser, Autoriser”. Tout comme le blocage des adresses IP, ajouter trop de bots à bloquer peut ralentir votre site internet.

Une fois que vous avez terminé la mise à jour de votre fichier, assurez-vous de l’enregistrer en tant que fichier “.htaccess” AVEC les guillemets inclus. Téléchargez votre fichier mis à jour ou flambant neuf sur votre site Web et vous devriez être à l’abri des adresses IP et des chaînes d’agent utilisateur que vous avez identifiées.

N’oubliez pas que ce correctif ne protégera pas votre site Web de tous les robots. En fait, il ne vous protège que des adresses IP et des chaînes d’agents utilisateur que vous avez bloquées.

Se débarrasser des robots malveillants de manière facile

Au début du blog, j’ai mentionné qu’il y avait de bons robots et de mauvais robots. Des services comme Cloudflare, SiteLock et Sucuri, utilisent de bons robots pour traiter automatiquement les bad bots (robots malveillants) entrants. Comme vous l’avez probablement vu ci-dessus de la manière la plus difficile, bien qu’il soit gratuit, c’est une solution longue et ardue, qui peut même ne pas protéger votre site web de la majorité des robots. Alternativement, SiteLock et Sucuri s’occuperont des robots spam pour vous, parmi beaucoup d’autres fonctionnalités.

Ces deux services analysent continuellement votre site Web à la recherche d’intrus et les suppriment s’ils sont détectés. D’autres correctifs pour votre site Web incluent l’élimination des backdoors et la correction des vulnérabilités. Des intrusions supplémentaires sont évitées sur votre site Web avec un pare-feu d’applications Web et la prévention contre les attaques DDoS. En plus de la sécurité que ces services offrent, SiteLock donne également aux utilisateurs l’accès à un CDN mondial pour accélérer votre site Web.

La chose importante à retenir de cette solution est qu’elle est facile, automatique et fiable. Vous n’avez pas à vous soucier de modifier vos fichiers ou de bloquer les adresses IP lorsque vous disposez d’un service comme SiteLock ou Sucuri, car ils feront tout cela pour vous et ils le feront beaucoup plus efficacement. SiteLock, Sucuri, ou un autre service de sécurité que vous pouvez trouver, protégera votre site Web contre les mauvais robots entrants et corrigera votre code pour s’assurer que rien de malveillant ne puisse arriver sur votre site Web.

Conclusion

Les bots jouent un grand rôle dans toute l’activité Internet de nos jours. Tandis qu’une partie de cette activité peut être néfaste pour l’activité de votre site Web, beaucoup d’autres sont là pour vous faciliter la vie. Protéger votre site contre les robots malveillants est devenu quelque chose de nécessaire. WordPress dispose dans son catalogue d’extensions diverses protections contre les robots malveillants.